BERT a été annoncé fin de l’année 2018. Un an plus tard, la mise à jour est en place dans les pays anglophones, mais quels en sont les impacts et les changements à prendre en compte ?

La plupart du temps, un internaute se rend sur Google pour rechercher une information dont il n’a pas la réponse, il cherche à se documenter. Or, il peut être parfois difficile pour Google de trouver la bonne réponse à une requête lorsque l’internaute ne sait pas comment la formuler clairement.

Au fur et à mesure des années, Google s’est beaucoup amélioré en essayant de comprendre ce que les utilisateurs recherchent comme informations lorsqu’ils tapent des mots-clés. Il souhaite maintenant, se perfectionner sur les requêtes dites du langage naturel, ou conversationnelle grâce au Machine Learning (processus dans lequel la machine apprend par elle-même, avec des données récoltées).

Qu’est-ce que c’est exactement le langage naturel ?

Aujourd’hui, avec l’apparition des objets connectés permettant de faire une recherche vocale, les internautes utilisent un langage parlé, ils s’adressent à la machine comme ils le feraient dans une réelle conversation avec une autre personne. Or jusqu’ici, ce que comprenait le mieux Google était les requêtes composées d’un ou plusieurs mots-clés.

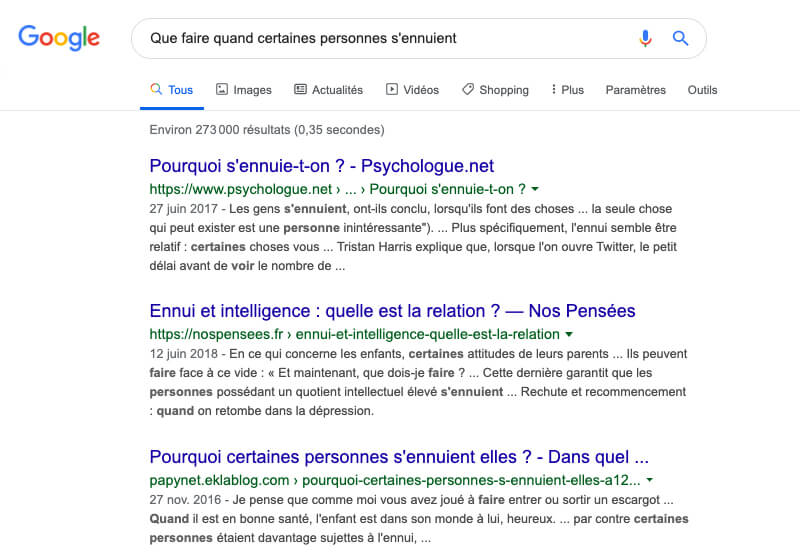

Pour illustrer ce qu’est le langage naturel, on peut utiliser l’exemple de la question : “Que faire quand certaines personnes s’ennuient ?”

→ On cherche une réponse qui nous donnerait une idée afin de remédier à ce problème. Cependant, les résultats affichés par Google peuvent ne pas être pertinents avec les intentions de la recherche. Nous pouvons ne pas trouver la réponse à notre question dans les éléments proposés par la SERP de Google, car le fond de la question n’a pas été compris par le moteur de recherche.

Dans cette requête, le moteur de recherche n’a analysé que le mot-clé “ennuie” sans comprendre le contexte de la question pouvant l’aider à afficher les bons résultats.

C’est pourquoi Google souhaite s’améliorer sur ce point. Il veut comprendre ce que l’utilisateur recherche lorsqu’il exprime sa requête de façon naturelle, avec un langage parlé. Il a alors mis en place l’algorithme BERT.

Bidirectional Encoder Representation from Transformers alias BERT

BERT est une importante mise à jour de l’algorithme Google Search. Il s’agit du réseau de neurones artificiels créé par Google ayant pour objectif de mieux comprendre le langage naturel de l’utilisateur. Elle concerne les requêtes de type longues, celles qui comportent beaucoup de mots et qui s’apparentent à une phrase.

Avant la mise à jour Google se basait sur les mots-clés tapés lors d’une recherche pour les mettre en relation avec du contenu similaire. Aujourd’hui avec l’algorithme BERT, c’est l’ensemble des mots qui ont un sens au sein du contenu.

BERT veut comprendre précisément la relation qu’ont les différents mots dans une phrase, leur place, leur importance et ce qu’ils signifient afin d’obtenir des résultats toujours plus précis. Pour cela, il doit analyser la requête dans son ensemble et plus seulement en prenant en compte des mots-clés individuellement.

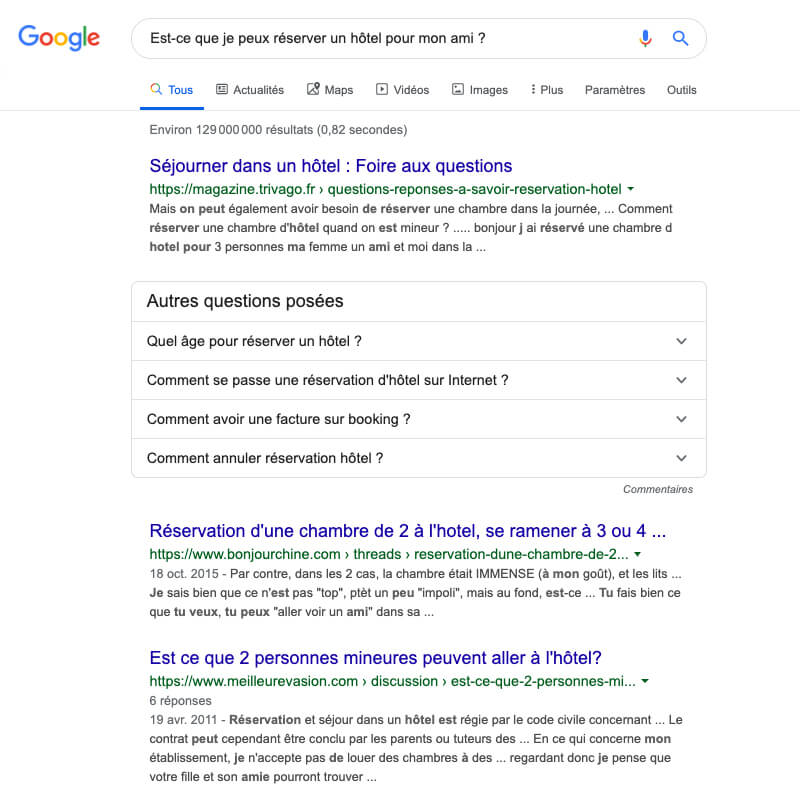

Prenons un exemple avec la requête « Est-ce que je peux réserver un hôtel pour mon ami ? »

→ Google a analysé les mots-clés “réserver” et “hôtel” mais il n’a pas compris que “pour un ami” était aussi un élément important dans la question.

Avec le nouvel algorithme BERT, la requête sera mieux analysée pour proposer des articles qui répondront plus précisément à la question posée.

Cependant, cette mise à jour n’impactera, pour le moment, qu’une requête sur dix, mais Google espère que nous prenions par la suite, l’habitude de ne plus seulement chercher par des mots-clés et que nous nous tournions petit à petit vers des requêtes larges du langage naturel.

Le fonctionnement de BERT

L’algorithme BERT utilise 2 stratégies pour comprendre le sens des requêtes :

1. Le langage masqué

BERT va tenter de prédire la suite de la requête. C’est une méthode qui consiste à masquer avec ce que l’on appelle un jeton [MASK] certains mots aléatoirement afin de les prédire (en général, il s’agit de 15 % de la requête). L’algorithme va devoir analyser la phrase dans son ensemble pour deviner les mots pouvant être sous chaque jeton.

Par exemple : avec la requête “Acheter le livre les Misérables de Victor Hugo” l’algorithme verra “Acheter le [MASK] les Misérable de [MASK] Hugo”.

→ Il analysera la requête pour anticiper ce qui peut se trouver derrière les masques.

2. La prédiction de la phrase suivante

BERT analyse des phrases bidirectionnelles, c’est-à-dire, qu’il est capable d’analyser et de juger si deux phrases sont liées ou non.

Par exemple, si nous prenons une phrase 1 et une phrase 2 avec :

Phrase 1 : mon ordinateur ne se connecte pas à Internet.

Phrase 2 : on ne peut pas commencer la visioconférence.

→ Les deux phrases sont liées

Phrase 1 : mon ordinateur ne se connecte pas à Internet.

Phrase 2 : ma tasse à café est prête.

→ Les deux phrases ne sont pas liées

L’algorithme va classifier les deux phrases et calculer la probabilité pour savoir si elles sont connectées entre elles afin de mieux comprendre le contexte de la recherche.

Conclusion

BERT ne mettra en avant plus que des contenus de qualité, il faut donc bien affiner son contenu pour être le plus précis et pertinent possible, car il ne favorisera naturellement plus les sites avec du contenu négligé.

Pour le moment, l’algorithme n’est disponible que dans les pays anglophones, car l’intelligence artificielle de l’algorithme a la capacité d’apprendre aux autres langues à reproduire le même schéma. Les premiers tests ont donc commencés aux États-Unis et arriveront en France très prochainement !

BERT, n’est pas un projet fixe, il sera amené à évoluer constamment, mais à l’heure actuelle, il s’agit déjà d’une grande avancée.

Pour la suite, une autre avancée est déjà prévue au planning, il s’agit de l’algorithme ALBERT qui devrait succéder à BERT en proposant une amélioration au niveau de sa taille et de son poids, à suivre !

Si cet article vous a plu, faites un tour sur notre blog pour plus de lecture !